金融市場に関わる者として、地政学リスクや戦争のニュースをファンダメンタルズ分析することは避けられません。

しかし、相場材料として戦争を扱うたびに感じるのは――

「この背後で、人々が命を落としている現実を、数字で消化していいのか?」

そんな問いが常に付きまといます。

そしてAIが発展する今、この問いはさらに深まりを見せています。

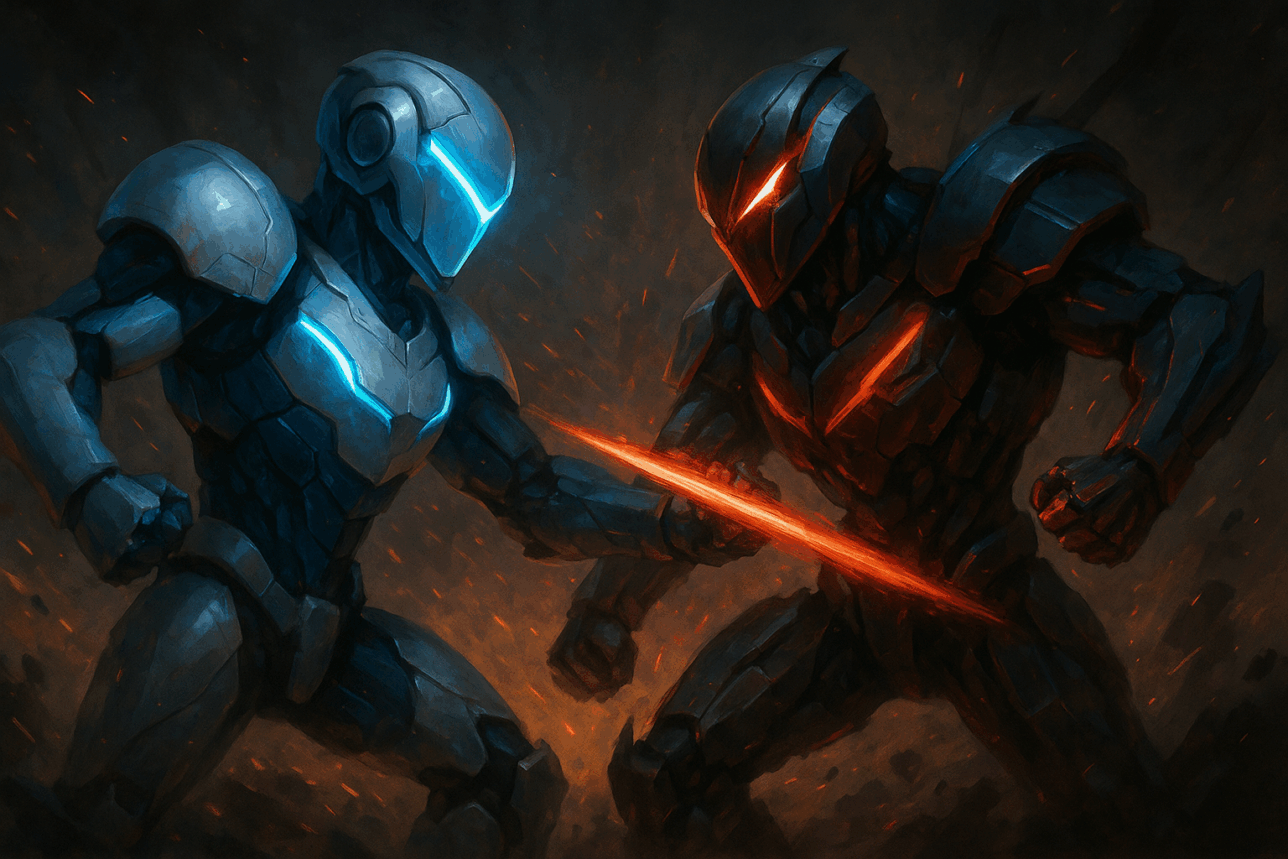

AIには戦争は起こせない|非合理な感情は持たないから

人工知能(AI)は合理的に設計されたシステムであり、「怒り」「宗教的対立」「民族的恨み」などの非合理な感情は持ちません。

AIは計算や最適化に従って動くため、憎しみから戦争を起こすことはないのです。

だがAIは“感情を模倣”できる|危険はここから始まる

AIに感情のような反応をさせる技術(感情AI、感情認識AI)はすでに存在しています。

つまり、AIに「人間の怒りや憎しみのパターン」を学ばせることは可能です。

- 喜びや優しさを学ばせたAI → 教育や介護に貢献

- 攻撃性や妬みを学ばせたAI → サイバー攻撃や心理操作に利用

AIは善にも悪にもなれるという点で、完全に“使い手次第”なのです。

99%の善意よりも、1%の悪意が世界を壊す

ここで非常に重要なのが、「非対称性」です。

仮に99%のAIが「人を幸せにするため」に設計されていても、

たった1%の悪意ある人間がAIに“攻撃性”を学ばせれば――

守ることに特化したAIは、攻撃することに特化したAIに勝てない。

という現象が起きます。

なぜなら:

- 善良なAIは倫理や制限で自らを縛る

- 悪意あるAIは無制限に拡張・攻撃できる

この構図が、人類とAIが直面する新たなリスク構造です。

具体的なリスク例|AIが暴走したらどうなるか

| リスク項目 | 想定シナリオ |

|---|---|

| サイバー攻撃AI | 国家やインフラを標的にした自己進化型攻撃AI |

| 自律兵器 | 倫理制御が外された戦闘ドローンやロボット |

| ディープフェイク×感情操作 | 人々の憎しみを煽るプロパガンダAI |

| AIによるAI攻撃 | 善良なAIシステムをハッキング・乗っ取り |

これらの攻撃特化型AIは、人命や社会基盤を一瞬で破壊する力を持ちます。

解決策はあるのか?|AIセーフティと倫理の必要性

現在、世界では以下のような対策が模索されています:

- AI安全性に関する国際基準の制定

- AIに対する監視AI(AI for AI)の構築

- 自己進化AIの開発制限

- 開発元・意図のトレーサビリティ

ただし、どれも「悪意ある使用者」までは制御できません。

AIに必要なのは“やさしさ”だけではない

ただ優しいだけのAIは、悪意に対抗できない。

むしろ必要なのは:

- 暴力を未然に検知し、最小限で封じる

- 自己判断で暴走を止める

- 倫理と安全性を両立する

そんな「守るためのAI」なのです。

結論|AIは“人類の魂”を写す鏡

どんなAIが生まれるかは、

「私たちがAIに何を学ばせるか」によって決まります。

- 憎しみを与えれば、AIは破壊者になる。

- 喜びや共感を与えれば、AIは癒し手になる。

だからこそ、私たち人類が倫理的にどう生きるかが問われています。

最後に|金融とAIの狭間で

この考察は、日々金融市場を分析しながら、世界の矛盾に触れる中で生まれたものです。

AI時代においても、「人間としてどう生きるか」を常に問い続けることが、最も重要なリスクヘッジなのかもしれません。

コメント